Die 11 wichtigsten RAG-Strategien für Ihr Unternehmen

Entdecken Sie 11 bewährte RAG-Strategien für präzisere KI-Antworten: Von Reranking bis Knowledge Graphs – mit konkreten Empfehlungen für Ihre Implementierung.

Ihr RAG-System liefert ungenaue Antworten?

Sie haben ein RAG-System implementiert, doch die Antwortqualität bleibt hinter Ihren Erwartungen zurück. Der KI-Chatbot findet nicht die richtigen Dokumente, gibt irrelevante Informationen zurück oder halluziniert trotz vorhandener Wissensbasis. Dieses Problem kennen viele Unternehmen – und es liegt selten am Grundkonzept.

Die Herausforderung: Es existieren über ein Dutzend verschiedene RAG-Strategien zur Optimierung. Welche davon passen zu Ihrem Use Case? Sollten Sie mehrere kombinieren? Die Antworten auf diese Fragen entscheiden über den Erfolg Ihrer RAG-Implementierung.

Dieser Artikel gibt Ihnen einen systematischen Überblick über alle 11 relevanten RAG-Strategien. Sie erfahren, welche Vor- und Nachteile jede Strategie bietet und welche Kombination aus drei bis fünf Strategien für die meisten Unternehmensanwendungen optimal ist.

RAG im Überblick: Warum Optimierung entscheidend ist

Bevor wir in die einzelnen Strategien einsteigen, lohnt sich ein kurzer Blick auf die RAG-Grundlagen. Das Verständnis der beiden Kernphasen hilft Ihnen, die Optimierungsansätze besser einzuordnen.

Die zwei Phasen eines RAG-Systems

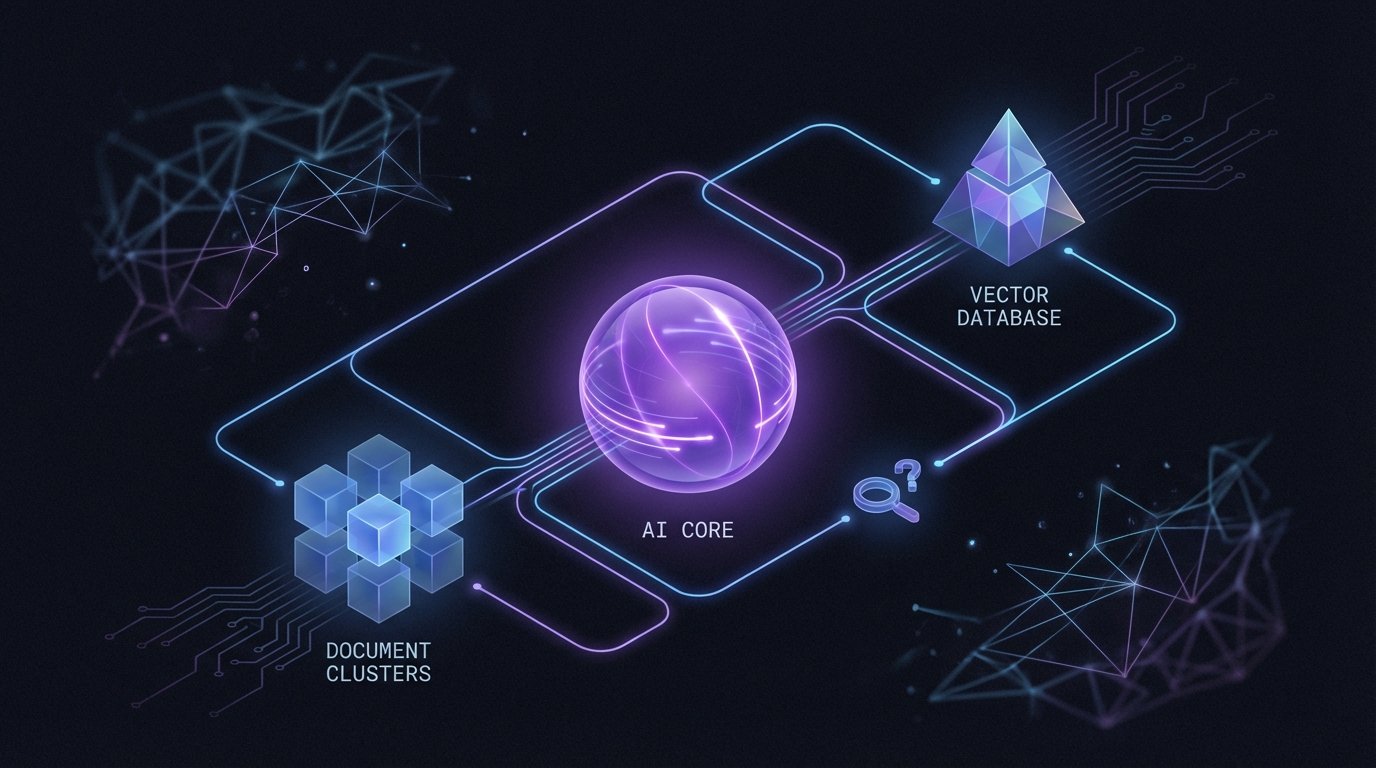

Phase 1 – Datenaufbereitung: Ihre Dokumente werden in kleinere Abschnitte (Chunks) aufgeteilt, durch ein Embedding-Modell in Vektoren umgewandelt und in einer Vektordatenbank gespeichert. Alternativ oder ergänzend können Informationen auch in einem Knowledge Graph abgelegt werden.

Phase 2 – Abfrage und Generierung: Eine Nutzerfrage wird ebenfalls in einen Vektor umgewandelt. Die Vektordatenbank findet ähnliche Chunks, die dann zusammen mit der Frage an das Large Language Model gehen. Das LLM generiert eine Antwort basierend auf dem bereitgestellten Kontext.

Das Problem der Standard-Implementierung

Eine Basis-RAG-Implementierung mit LangChain oder LlamaIndex ist schnell aufgesetzt. Doch ohne weitere Optimierung treten typische Probleme auf: Das System liefert zu viele irrelevante Chunks, übersieht wichtige Zusammenhänge oder das LLM wird mit zu viel Kontext überfrachtet.

Genau hier setzen die folgenden elf Strategien an – aufgeteilt in Optimierungen für die Abfragephase und für die Datenaufbereitung.

Die 11 RAG-Strategien im Detail

1. Reranking – Der Qualitätsfilter

Reranking ist die erste Strategie, die Sie bei fast jeder RAG-Implementierung einsetzen sollten. Das Prinzip: ein zweistufiger Retrieval-Prozess.

Im ersten Schritt holt das System eine größere Anzahl von Chunks aus der Vektordatenbank – beispielsweise 20 oder 50 Treffer. Im zweiten Schritt bewertet ein spezialisiertes Reranker-Modell (oft ein Cross-Encoder) die tatsächliche Relevanz jedes Chunks zur ursprünglichen Frage. Nur die besten drei bis fünf Chunks werden an das LLM weitergegeben.

Vorteil: Das LLM erhält ausschließlich hochrelevante Informationen und wird nicht mit irrelevanten Chunks überfrachtet. Gleichzeitig berücksichtigt das System einen größeren Wissenspool.

Aufwand: Gering. Sie benötigen lediglich ein zusätzliches Reranker-Modell, die Kosten sind überschaubar.

Empfehlung: Implementieren Sie Reranking als Basis für jedes produktive RAG-System.

2. Agentic RAG – Flexible Suchstrategien

Bei Agentic RAG erhält Ihr KI-Agent die Fähigkeit, selbst zu entscheiden, wie er die Wissensbasis durchsucht. Statt einer starren Pipeline kann der Agent verschiedene Werkzeuge wählen: klassische semantische Suche, Volltextsuche mit Filtern oder das Lesen eines kompletten Dokuments.

In der Praxis bedeutet das: Sie speichern sowohl einzelne Chunks als auch Metadaten zu ganzen Dokumenten. Der Agent analysiert die Nutzerfrage und wählt die passende Suchstrategie. Bei einer Detailfrage nutzt er die Chunk-Suche, bei einer Übersichtsfrage liest er möglicherweise ein ganzes Dokument.

Vorteil: Maximale Flexibilität für unterschiedliche Fragetypen.

Aufwand: Mittel. Sie benötigen klare Instruktionen für den Agenten, wann welche Suchstrategie sinnvoll ist.

Empfehlung: Ideal für komplexe Wissensbasen mit verschiedenen Dokumenttypen.

3. Knowledge Graphs – Beziehungen nutzen

Knowledge Graphs erweitern Ihr RAG-System um eine zusätzliche Dimension: die Beziehungen zwischen Entitäten. Neben der Vektorsuche kann der Agent nun auch durch ein Netzwerk aus Personen, Produkten, Prozessen und deren Verbindungen navigieren.

Technisch extrahiert ein LLM Entitäten und deren Beziehungen aus Ihren Dokumenten. Diese werden in einer Graph-Datenbank gespeichert. Bei einer Anfrage kann das System sowohl semantisch ähnliche Chunks finden als auch verwandte Entitäten über den Graph erschließen.

Vorteil: Hervorragend für stark vernetzte Daten, bei denen Zusammenhänge wichtiger sind als einzelne Textpassagen.

Aufwand: Hoch. Die LLM-basierte Extraktion ist zeitaufwändig und kostenintensiv.

Empfehlung: Sinnvoll bei komplexen Domänen mit vielen Querverbindungen – etwa Produktkataloge mit Abhängigkeiten oder Organisationsstrukturen.

4. Contextual Retrieval – Chunks anreichern

Diese von Anthropic entwickelte Strategie verbessert die Qualität Ihrer Embeddings. Für jeden Chunk generiert ein LLM eine kurze Beschreibung, die erklärt, wie dieser Abschnitt in den Gesamtkontext des Dokuments passt.

Der generierte Kontexttext wird dem Chunk vorangestellt und gemeinsam embedded. Das Ergebnis: Die Vektorsuche berücksichtigt nun nicht nur den Chunk-Inhalt, sondern auch dessen Bedeutung im Dokumentzusammenhang.

Vorteil: Deutlich verbesserte Retrieval-Qualität, da Chunks nicht isoliert betrachtet werden.

Aufwand: Hoch. Für jeden Chunk ist ein LLM-Call erforderlich, was Zeit und Kosten verursacht.

Empfehlung: Lohnenswert bei statischen Wissensbasen, die selten aktualisiert werden.

5. Query Expansion – Präzisere Suchen

Query Expansion ist eine der einfachsten Optimierungen. Bevor die Nutzerfrage an die Vektordatenbank geht, erweitert ein LLM die Anfrage um relevante Details und Synonyme.

Aus "Wie funktioniert die Rückgabe?" wird beispielsweise "Wie funktioniert der Rückgabeprozess für Produkte? Welche Fristen gelten für Retouren und Umtausch?". Die erweiterte Anfrage führt zu präziseren Suchergebnissen.

Vorteil: Höhere Treffergenauigkeit bei vagen oder kurzen Anfragen.

Aufwand: Gering. Ein zusätzlicher LLM-Call pro Suche.

Empfehlung: Einfach zu implementieren und besonders hilfreich bei Endnutzer-Anwendungen mit kurzen Fragen.

6. Multi-Query RAG – Breitere Abdeckung

Ähnlich wie Query Expansion, aber mit einem anderen Ansatz: Statt eine Anfrage zu erweitern, generiert das LLM mehrere verschiedene Varianten der ursprünglichen Frage. Diese werden parallel an die Datenbank geschickt.

Die Ergebnisse aller Suchen werden zusammengeführt und dedupliziert. So erfassen Sie verschiedene Aspekte einer Frage, die bei einer einzelnen Suche möglicherweise übersehen würden.

Vorteil: Umfassendere Ergebnisse durch verschiedene Suchperspektiven.

Aufwand: Mittel. Mehrere Datenbankabfragen erhöhen Latenz und Kosten.

Empfehlung: Sinnvoll bei komplexen Fragen, die mehrere Themenbereiche berühren.

7. Context-Aware Chunking – Intelligentes Aufteilen

Wechseln wir zur Datenaufbereitung. Context-Aware Chunking verbessert die Art, wie Dokumente in Chunks aufgeteilt werden. Statt starrer Zeichengrenzen (alle 1.000 Zeichen ein neuer Chunk) nutzt diese Methode ein Embedding-Modell, um natürliche Themenwechsel im Dokument zu erkennen.

Bibliotheken wie Dockling implementieren Hybrid Chunking, eine Form des Context-Aware Chunking. Das Ergebnis: Chunks, die thematisch zusammengehören und die Dokumentstruktur respektieren.

Vorteil: Bessere Embedding-Qualität, da Chunks semantisch sinnvolle Einheiten bilden. Zudem schnell und kostenfrei in der Ausführung.

Aufwand: Gering. Einmalige Implementierung bei der Datenaufbereitung.

Empfehlung: Sollte die Basis jedes RAG-Systems sein. Der Aufwand ist minimal, der Nutzen erheblich.

8. Late Chunking – Kontext bewahren

Late Chunking dreht den üblichen Prozess um: Das Embedding-Modell verarbeitet zuerst das gesamte Dokument, bevor es in Chunks aufgeteilt wird. Die resultierenden Token-Embeddings werden anschließend in Chunks gruppiert.

Der Vorteil: Jeder Chunk "kennt" den Kontext des gesamten Dokuments, da das Embedding vor der Aufteilung erfolgte. Dies erfordert jedoch Embedding-Modelle mit großem Kontextfenster.

Vorteil: Maximaler Dokumentkontext in jedem Chunk.

Aufwand: Sehr hoch. Die Implementierung ist komplex und erfordert spezielle Embedding-Modelle.

Empfehlung: Nur für fortgeschrittene Anwendungen mit spezifischen Anforderungen an den Dokumentkontext.

9. Hierarchical RAG – Präzision trifft Kontext

Hierarchical RAG arbeitet mit verschiedenen Granularitätsstufen. Chunks erhalten Metadaten über ihre Zugehörigkeit zu übergeordneten Einheiten – etwa welchem Kapitel oder Dokument sie entstammen.

Bei der Suche können Sie klein und präzise suchen (einzelne Absätze), aber groß zurückgeben (das gesamte Kapitel oder Dokument). So balancieren Sie Präzision bei der Suche mit ausreichend Kontext für die Antwortgenerierung.

Vorteil: Ideal wenn präzise Suche und umfassender Kontext gleichermaßen wichtig sind.

Aufwand: Mittel. Erfordert durchdachte Metadatenstrukturen.

Empfehlung: Besonders wertvoll bei strukturierten Dokumenten wie Handbüchern oder Vertragswerken.

10. Self-Reflective RAG – Selbstkorrektur

Self-Reflective RAG fügt eine Qualitätskontrolle ein. Nach dem Retrieval bewertet ein LLM die gefundenen Chunks: Passen sie wirklich zur Frage? Ist die Relevanz ausreichend?

Bei unzureichender Bewertung startet das System eine verfeinerte Suche. Dieser Loop wiederholt sich, bis die Qualität stimmt oder eine maximale Anzahl an Versuchen erreicht ist.

Vorteil: Automatische Qualitätssicherung ohne manuellen Eingriff.

Aufwand: Mittel. Zusätzliche LLM-Calls und potenzielle Verzögerungen durch Wiederholungen.

Empfehlung: Sinnvoll bei kritischen Anwendungen, wo falsche Informationen schwerwiegende Folgen hätten.

11. Fine-Tuned Embeddings – Domänenspezifisch

Die letzte Strategie betrifft das Embedding-Modell selbst. Statt eines generischen Modells trainieren Sie ein eigenes auf Ihren Unternehmensdaten. Das Modell lernt die spezifische Terminologie und Zusammenhänge Ihrer Domäne.

Studien zeigen Genauigkeitssteigerungen von 5 bis 10 Prozent. Ein kleineres, feingetuntes Open-Source-Modell kann größere generische Modelle in Ihrer Domäne übertreffen.

Vorteil: Optimale Anpassung an Ihre spezifische Fachsprache und Semantik.

Aufwand: Sehr hoch. Erfordert Trainingsdaten, ML-Infrastruktur und laufende Wartung.

Empfehlung: Nur bei ausreichend Daten und wenn generische Modelle nachweislich unzureichend performen.

Die optimale Kombination: Unsere Top-3-Empfehlung

Nach diesem Überblick stellt sich die Frage: Wo anfangen? Die Antwort: Kombinieren Sie drei bis fünf Strategien für optimale Ergebnisse. Unsere Empfehlung für den Einstieg:

1. Context-Aware Chunking bildet die Basis. Intelligentes Chunking verbessert alle nachfolgenden Schritte. Der Aufwand ist gering, der Nutzen sofort spürbar.

2. Reranking filtert die Ergebnisse. Mit minimalem Zusatzaufwand steigern Sie die Relevanz der an das LLM übergebenen Chunks erheblich.

3. Agentic RAG gibt Ihrem System Flexibilität. Der Agent wählt je nach Fragetyp die optimale Suchstrategie – von der Detailsuche bis zum Dokumentüberblick.

Diese Kombination deckt sowohl die Datenaufbereitung als auch die Abfragephase ab. Sie ist mit überschaubarem Aufwand implementierbar und liefert in den meisten Unternehmensszenarien deutlich bessere Ergebnisse als eine Basis-Implementierung.

Je nach Use Case können Sie anschließend weitere Strategien ergänzen: Knowledge Graphs für stark vernetzte Daten, Contextual Retrieval für statische Wissensbasen oder Self-Reflective RAG für kritische Anwendungen.

Fazit: RAG-Strategien gezielt einsetzen

Die Optimierung eines RAG-Systems erfordert keine Implementierung aller elf Strategien. Vielmehr geht es darum, die passenden drei bis fünf Ansätze für Ihren spezifischen Use Case zu identifizieren und sinnvoll zu kombinieren.

Starten Sie mit den Grundlagen: Context-Aware Chunking für saubere Datenaufbereitung und Reranking für relevantere Ergebnisse. Erweitern Sie dann schrittweise um Agentic RAG für mehr Flexibilität. Beobachten Sie die Ergebnisse, identifizieren Sie verbleibende Schwachstellen und wählen Sie gezielt weitere Strategien.

Der Unterschied zwischen einem mittelmäßigen und einem exzellenten RAG-System liegt nicht in der Anzahl der implementierten Strategien, sondern in deren durchdachter Auswahl und Abstimmung auf Ihre Anforderungen.

Nächster Schritt: Sie möchten ein RAG-System implementieren oder Ihre bestehende Lösung optimieren? Als BAFA-registrierter Berater unterstützen wir Sie bei der Strategieauswahl und Umsetzung – mit bis zu 80 Prozent Förderung der Beratungskosten. Vereinbaren Sie ein kostenloses Erstgespräch und lassen Sie uns gemeinsam die optimale RAG-Strategie für Ihr Unternehmen entwickeln.

Bereit für Ihre KI-Transformation?

Nutzen Sie die BAFA-geförderte Erstberatung und entdecken Sie Ihre individuellen KI-Potenziale. Bis zu 80% Zuschuss möglich.

BAFA-registrierter Berater | Bis zu 80% Förderzuschuss | Keine versteckten Kosten